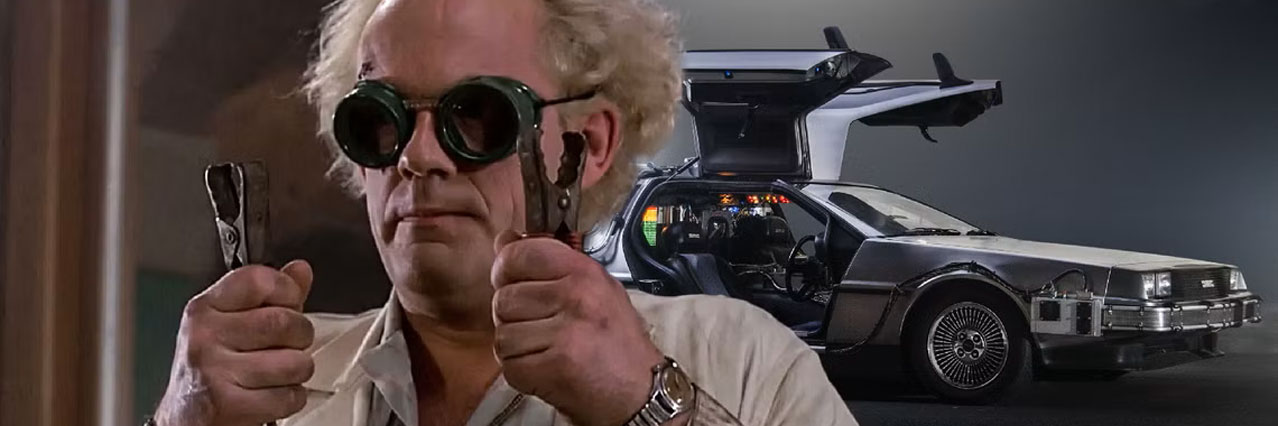

回到未来

Mar 24, 2025

本文论述强化学习(RL, Reinforcement Learning)在未来人工智能发展中的重要性为主线,同时探讨了基于监督微调大模型(SFT, Supervised Fine-Tuning)的局限性,以及为何强化学习是未来实现通用人工智能(AGI, Artificial General Intelligence)的方向。

从监督学习到强化学习转型的必然性

随着ChatGPT和DeepSeek等模型相继转向具备推理能力的新版本,事实上大模型已不再局限于监督学习(即通过海量的数据的学习)的范畴。我们正见证着训练方式从传统的基于文本和标签的大规模监督学习向强化学习转变。尽管大规模数据的监督学习让大模型积累了丰富的知识,但它们往往局限于语言中的逻辑和统计规律,并未能真正理解现实世界的本质。相比之下,采用强化学习的人形机器人,通过与环境互动实现自我行为的持续优化和修正,则更符合现实需求。

强化学习的历史与演进

强化学习并非一夜之间诞生的技术,而是经历了数十年的理论探索与实践验证。强化学习的思想可以追溯到20世纪初期的行为主义心理学。从爱德华·桑代克的试错法,到理查德·贝尔曼的动态规划,再到AlphaGo击败李世石,强化学习展示了其解决复杂问题的能力。2024年图灵奖授予了两位在该领域做出开创性贡献的研究者,彰显了强化学习在未来人工智能发展中的重要地位。

人类学习的本质:互动与反馈

尽管基于文本训练的大模型能够捕捉到语言中隐含的逻辑关系,但这仅仅是一种知识的抽象。它们主要依靠海量语料库中的统计规律和模式识别来生成内容,而缺乏与真实世界互动所必需的动态适应能力。这样的模型终归无法具备真正意义上的人类认知能力,因为人类的知识不仅来源于书本,更源于日常生活中对环境的不断感知、体验和总结。观察人类学习的过程,我们会发现其核心在于不断与外界进行互动,通过试错、反馈和调整来积累经验。无论是婴儿在爬行中探索世界,还是成年人在工作中不断总结经验,互动始终是知识获得和技能提升的关键。强化学习正是模仿这一机制,使得机器可以在不断的实践中自我进化。这种学习方式更贴近人类的认知过程。

结语

总的来看,真正的智能,必定源自于与世界的不断碰撞和反馈。强化学习则以其与真实世界互动、不断进化的特性展现了无限可能。而依赖海量数据与模式识别的大模型,则可能只能作为一个过渡阶段,无法满足人类对于智能更高层次的渴望。未来的人工智能,必将是在人与世界持续互动中不断成长和超越的存在。